¿Necesita más convencimiento de que pronto será imposible saber si un video de una persona es real o falso? Ingrese a la nueva investigación de Samsung, en la que una red neuronal puede convertir una imagen fija en un video perturbadoramente convincente.

SAMSUNG AI CENTER, MOSCOW

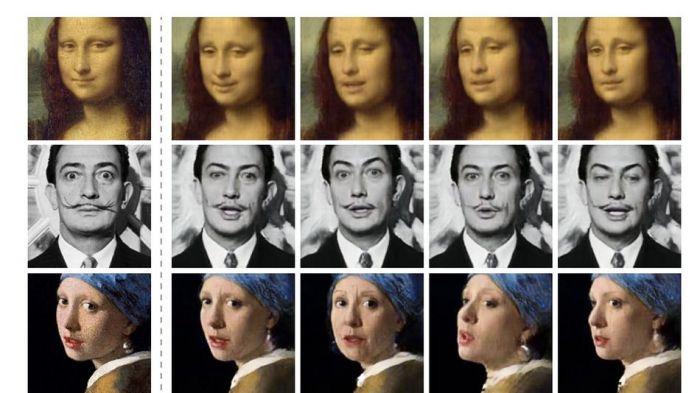

Los investigadores del centro de inteligencia artificial de Samsung en Moscú lograron esto, informó Motherboard el jueves, al capacitar a una «red de convolución profunda» en una gran cantidad de videos que muestran cabezas que hablan, lo que le permite identificar ciertos rasgos faciales y luego usar ese conocimiento para animar una imagen.

Los resultados, presentados en un artículo titulado «Aprendizaje adverso de pocas tomas de modelos realistas de cabezas parlantes neuronales«, no son tan buenos como algunos de los videos deepfake que has visto, pero para crearlos, necesitas una gran cantidad de imágenes de la persona que estás tratando de animar.

La ventaja del enfoque de Samsung es que puede convertir una sola imagen fija (aunque la fidelidad del video resultante aumenta con más imágenes) en un video.

Puedes ver algunos de los resultados de esta investigación en el video, a continuación. Utilizando una sola imagen fija de Fyodor Dostoevsky, Salvador Dali, Albert Einstein, Marilyn Monroe e incluso Mona Lisa, la IA pudo crear videos de ellos que son lo suficientemente realistas (en momentos) para que parezcan imágenes reales.

Ninguno de estos videos engañará a un experto, ni a nadie que lo vea lo suficientemente cerca. Pero como hemos visto en investigaciones anteriores sobre imágenes generadas basadas en la IA, los resultados tienden a mejorar enormemente en cuestión de años.

Las implicaciones de esta investigación son escalofriantes. Armado con esta herramienta, solo se necesita una foto de una persona (que en la actualidad es fácil de obtener para la mayoría de las personas) para crear un video de ellos hablando.

Agregue a eso una herramienta que puede usar fragmentos cortos de material de audio de muestra para crear la voz falsa y convincente de una persona y uno puede hacer que cualquiera «diga» cualquier cosa.

Y con herramientas como la GAN de Nvidia, uno podría incluso crear una configuración falsa de aspecto realista para un video de este tipo. A medida que estas herramientas se vuelven más poderosas y fáciles de obtener, será más difícil distinguir videos reales de videos falsos; con suerte, las herramientas para discernir entre los dos también serán más avanzadas.