Este es un software para salvar vidas. La nueva tecnología de inteligencia artificial (IA) de «detección proactiva» de Facebook escaneará todos los post en busca de patrones de pensamientos suicidas y, cuando sea necesario, enviará recursos de salud mental al usuario en riesgo o a sus amigos, o se pondrá en contacto con los primeros en responder.

Al usar Inteligencia Artificial para señalar mensajes preocupantes a los moderadores humanos en lugar de esperar los informes de los usuarios, Facebook puede reducir el tiempo que lleva enviar ayuda.

Facebook ha probado previamente el uso de la inteligencia artificial para detectar publicaciones problemáticas, y hará más prominentes las opciones de reporte de suicidio para amigos en los Estados Unidos. Ahora, Facebook explorará todo tipo de contenido en todo el mundo con esta IA, excepto en la Unión Europea, donde las leyes de privacidad del Reglamento General de Protección de Datos y su sección acerca de perfilar usuarios basados en información sensible, complican el uso de esta tecnología.

Facebook también utilizará IA para priorizar reportes de usuarios particularmente riesgosos o urgentes, de modo que los moderadores los aborden más rápidamente y facilitará herramientas para que aparezcan instantáneamente los recursos del idioma local y la información de contacto de los primeros respondedores. También está dedicando más moderadores a la prevención del suicidio, capacitándolos para lidiar con los casos las 24 horas del día los 7 días de la semana, y ahora cuenta con 80 socios locales como Save.org, National Suicide Prevention Lifeline y Forefront a partir de los cuales puede proporcionar recursos a los usuarios en riesgo y sus redes.

«Se trata de reducir los minutos en cada paso del proceso, especialmente en Facebook Live», dice el vicepresidente de gestión de producto, Guy Rosen. Durante el último mes de pruebas, Facebook ha iniciado más de 100 «controles de bienestar» con primeros respondedores visitando a los usuarios afectados. «Han habido casos en que ha llegado el primer respondedor y la persona todavía está transmitiendo».

La idea de que Facebook escanee proactivamente el contenido de las publicaciones de las personas podría provocar algunos temores distópicos sobre de qué otra forma podría aplicarse la tecnología. Facebook no tenía respuestas sobre cómo evitaría el escaneo de disidencia política o delitos menores, y Rosen simplemente dijo «tenemos la oportunidad de ayudar aquí, así que vamos a invertir en eso». Sin duda hay aspectos beneficiosos masivos sobre la tecnología, pero es otro espacio donde no tenemos otra opción más que esperar que Facebook no vaya demasiado lejos.

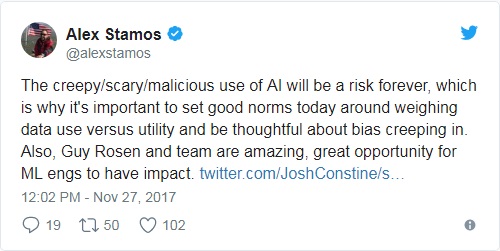

El jefe de seguridad de Facebook Alex Stamos respondió a estas inquietudes con un tweet alentador que indica que Facebook sí se toma en serio el uso de la IA.

«El uso espeluznante / aterrador / malicioso de la IA será un riesgo para siempre, por lo que es importante establecer buenas normas hoy en día para sopesar el uso de datos versus la utilidad y ser precavido con las tendencias que se filtran. Además, Guy Rosen y su equipo son una gran oportunidad. para que ML engs tenga impacto».

El Director Ejecutivo de Facebook, Mark Zuckerberg, elogió la actualización del producto en un post y escribió que «En el futuro, la IA podrá comprender más los matices sutiles del lenguaje y podrá identificar diferentes problemas además del suicidio, incluyendo detectar rápidamente más tipos de acoso y odio».

Desafortunadamente, después de que se le preguntara si había una forma para que los usuarios se excluyeran, de permitir el acceso a sus publicaciones, un vocero de Facebook respondió que los usuarios no pueden optar por no participar. Señalaron que la función está diseñada para mejorar la seguridad del usuario, y que los recursos de soporte ofrecidos por Facebook se pueden descartar rápidamente si un usuario no quiere verlos.

Facebook entrenó a la IA al encontrar patrones en las palabras e imágenes usadas en publicaciones que se han reportado manualmente por riesgo de suicidio en el pasado. También busca comentarios como «¿estás bien?» Y «¿Necesitas ayuda?»

«Hemos hablado con expertos en salud mental, y una de las mejores formas de ayudar a prevenir el suicidio es que las personas necesitadas sepan que sus familias y amigos se preocupan por ellos«, dice Rosen. «Esto sitúa a Facebook en una posición única. Podemos ayudar a conectar a personas con síntomas con amigos y organizaciones que pueden ayudarles.».

Cómo el reporte de suicidio funciona en Facebook ahora

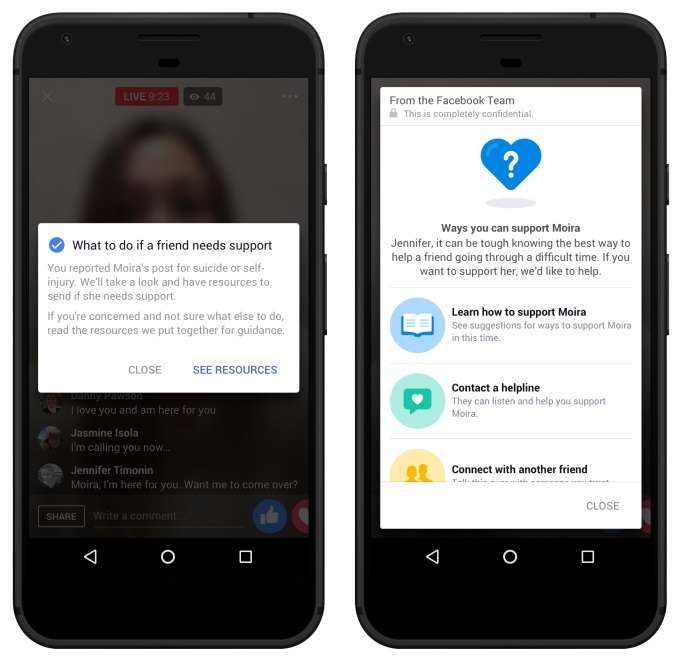

A través de la combinación de IA, moderadores humanos y reportes de colaboración colectiva, Facebook podría tratar de evitar tragedias como cuando un padre se suicidó en Facebook Live el mes pasado. Las transmisiones en vivo en particular tienen el poder de glorificar erróneamente el suicidio, de ahí las nuevas precauciones necesarias, y también para afectar a una gran audiencia, ya que todos ven el contenido simultáneamente, a diferencia de los videos grabados en Facebook que pueden marcarse y bajarse antes de ser vistos por mucha gente.

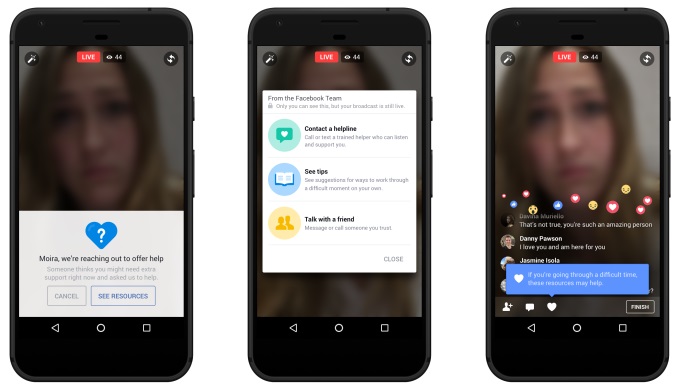

Ahora, si alguien está expresando pensamientos suicidas en cualquier tipo de publicación de Facebook, la IA de Facebook lo detectará de manera proactiva y lo señalará a moderadores humanos capacitados en prevención, y hará que las opciones de creación de reportes para los espectadores sean más accesibles.

Cuando llega un reporte, la tecnología de Facebook puede destacar la parte de la publicación o video que coincide con los patrones de riesgo de suicidio o que recibe comentarios de preocupación. Eso evita que los moderadores tengan que hojear un video completo ellos mismos. La IA prioriza los reportes de los usuarios como más urgentes que otros tipos de infracciones de política de contenido, como la descripción de violencia o desnudez. Facebook dice que estos informes acelerados se extienden a las autoridades locales dos veces más rápido que los informes no acelerados.

Las herramientas de Facebook luego sacan a relucir los recursos del idioma local de sus socios, incluidas líneas directas de atención telefónica para la prevención del suicidio y las autoridades cercanas. El moderador puede ponerse en contacto con los respondedores e intentar enviarlos a la ubicación del usuario en riesgo, mostrar los recursos de salud mental al usuario en riesgo o enviarlos a amigos que pueden hablar con el usuario. «Uno de nuestros objetivos es garantizar que nuestro equipo pueda responder en todo el mundo en cualquier idioma que admitamos», dice Rosen.

Ya en febrero, el Director Ejecutivo de Facebook, Mark Zuckerberg, escribió que «ha habido eventos terriblemente trágicos, como suicidios, algunos transmitidos en vivo, que quizás podrían haberse evitado si alguien se hubiera dado cuenta de lo que estaba sucediendo y los hubiera informado antes». . . La inteligencia artificial puede ayudar a proporcionar un mejor enfoque«.

Con más de 2 mil millones de usuarios, es bueno ver cómo Facebook se refuerza en este punto. Facebook no solo ha creado una forma para que los usuarios se comuniquen y se cuiden entre sí. Desafortunadamente, también creó un canal de distribución en tiempo real sin mediación en Facebook Live que puede atraer a personas que quieren una audiencia para la violencia que se infligen a sí mismos o a los demás.

Crear una herramienta de comunicación global omnipresente viene con responsabilidades más allá de las de la mayoría de las compañías tecnológicas; responsabilidades que Facebook parece estar aceptando.